KI in der Demokratie – Chancen und Anforderungen

16. 12. 2025

Im Projekt “Chancen von KI zur Stärkung unserer deliberativen Kultur” (KIdeKu) haben wir in den vergangenen zwei Jahren ausgelotet, wie generative KI dazu beitragen kann, die öffentliche Diskurslandschaft und die politische Willensbildung im Sinne der Ideale liberaler Demokratien zu stärken. Dazu haben wir Einsatzszenarien untersucht, eigene Prototypen entwickelt und unterschiedliche KI-Anwendungen auf dem KIdeKu-Workshop diskutiert – hier findet Ihr Antworten auf die Frage, wie KI Demokratie durch Vertrauen gestärkt werden kann und welche Empfehlungen wir für deliberative Kontexte haben.

Generative Sprachmodelle und die damit verbundene Zunahme von KI-generierten Inhalten verändern die Informationsproduktion und Informationsverarbeitung rasant. Manipulative Akteure können diese Technologien nutzen, um liberale Demokratien zu schwächen. Generative KI stellt aber nicht nur ein Risiko, sondern auch eine Chance dar, um unsere deliberative Kultur zu stärken.

Mehr Infos dazu auch in unseren anderen Beiträgen, beispielsweise in diesem Blog zu demokratisch gestalteter digitaler Infrastruktur

Dabei geht es nicht nur darum, den durch KI ermöglichten neuen Problemen (KI-Slop, Deep Fakes, KI-basierte Desinformationskampagnen) eine KI-basierte Lösung entgegenzustellen, sondern Deliberation und demokratische Prozesse auf ganz unterschiedlichen Ebenen durch KI zu unterstützen. So haben wir uns beispielsweise gefragt, wie generative Sprachmodelle in deliberativen Kontexten benutzt werden können

- um eine hinreichend hohe argumentative Qualität sicherzustellen,

- um Bürger:innen unabhängig vom Bildungshintergrund zu befähigen, sich konstruktiv mit Argumenten anderer auseinanderzusetzen und eigene Argumente einzubringen und

- um Zugangs- und Beteiligungshürden für demokratische Teilhabe abzubauen.

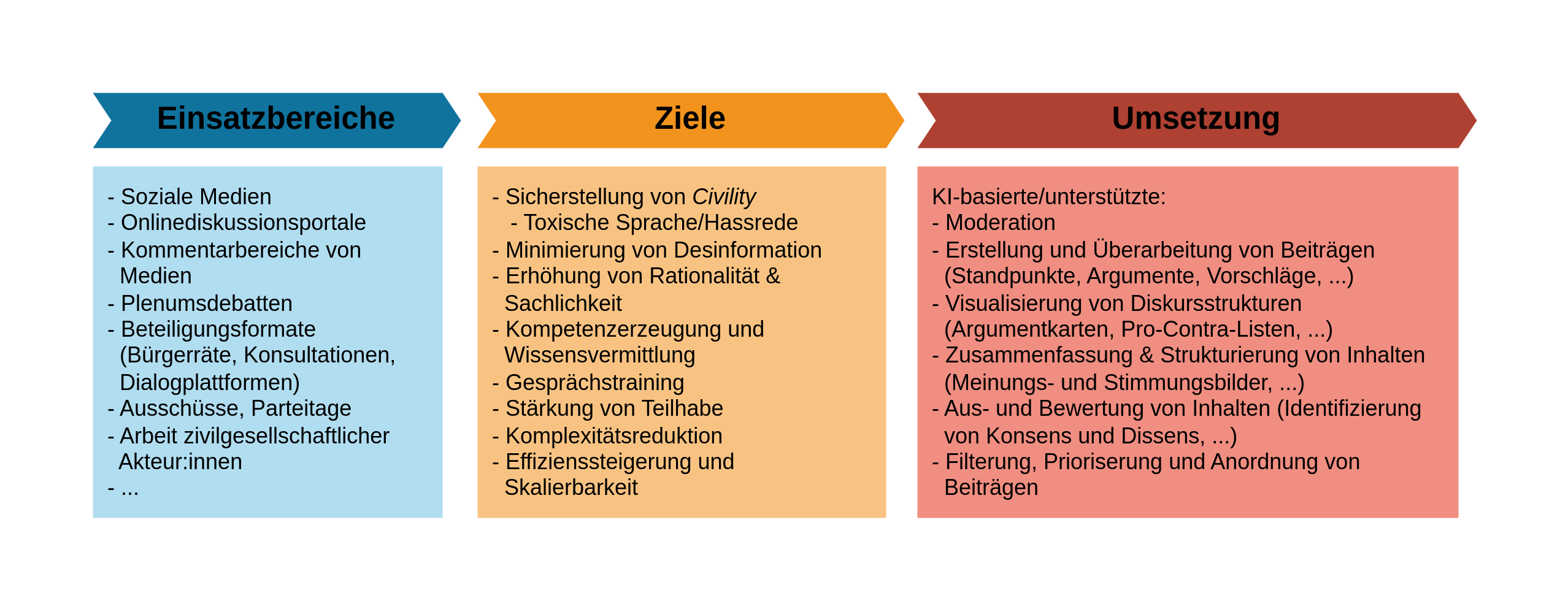

Die möglichen Einsatzszenarien lassen sich dabei anhand der folgenden drei Dimensionen charakterisieren (siehe Abbildung):

- Einsatzbereich: In welchen deliberativen Kontexten soll KI eingesetzt werden?

- Ziele: Welche Ziele sollen durch den Einsatz von KI in diesem Einsatzbereich erreicht werden?

- Umsetzung & Funktion: Wie soll KI konkret eingesetzt werden, um die Ziele zu erreichen?

Möglich ist beispielsweise der Einsatz von KI in Onlinediskussionsportalen (Einsatzbereich), um ein Mindestmaß an Höflichkeit und Respekt sicherzustellen (Ziel), indem die KI Äußerungen darauf hin prüft, ob sie möglicherweise Hassrede enthalten. Ein solches KI-Detektionstool kann für die Moderation assistierend eingesetzt werden und dabei Moderat*innen entlasten und/oder Teilnehmende auf problematische Äußerungen schon während der Beitragserstellung hinweisen und entsprechende Reformulierungen vorschlagen. Finale Moderations- und Formulierungsentscheidungen verbleiben in diesem Szenario bei Menschen. Neben solchen “konservativen” Szenarien sind aber auch ambitioniertere Zukunftsvisionen denkbar wie beispielsweise die Idee von KI-Zwillingen. In diesem Szenario verfügen Bürger*innen über individuelle KI-Zwillinge, die ihre politischen Überzeugungen, Argumentationsstile und normativen Einstellungen widerspiegeln und in deliberativen Kontexten stellvertretend für sie agieren. Diese KI-Zwillinge nehmen an Diskussionen teil, reagieren auf Argumente anderer und bringen Positionen ein, ohne dass ihre menschlichen Vorbilder ständig selbst präsent sein müssen.

Vertrauen & Verlässlichkeit: Besonderheiten und Herausforderungen

Der Einsatz von KI-basierten Applikationen kann nur dann unsere demokratische Kultur stärken, wenn diese Applikationen von Nutzer*innen genutzt werden, was wiederum ein hinreichend großes Vertrauen in die Sicherheit und Verlässlichkeit solcher Anwendungen voraussetzt. Im Folgenden werden einige allgemeine Überlegungen zur Rolle von Transparenz und Verlässlichkeit für Vertrauen dargestellt.[1]

Warum sind Vertrauen und Akzeptanz im Kontext KI-gestützter Deliberation so wichtig?

Deliberative Kontexte zeichnen sich durch ihre besondere Rolle für demokratische Teilhabe aus. In ihnen üben Bürger*innen ihre politischen Rechte aus. Bürger*innen nehmen hier mittelbar oder unmittelbar an der politischen Willensbildung teil, indem sie beispielsweise ihre Überzeugungen im öffentlichen Diskurs ausdrücken oder politische Selbstwirksamkeit in Beteiligungsformaten wie Bürgerräten erleben. Daher ist zu erwarten, dass Bürger*innen auf Einschränkungen dieser Teilhaberechte sehr sensibel reagieren. KI-gestützter Deliberation geht es also nicht nur darum, dass Nutzer*innen genervt sind, wenn etwas nicht richtig funktioniert, und als Konsequenz zum Produkt eines Konkurrenten wechseln. Vielmehr besteht die Gefahr, dass sie sich in der Ausübung ihrer bürgerlichen Teilhaberechte eingeschränkt fühlen. Sie könnten sich durch den Einsatz von KI missrepräsentiert, ausgeschlossen oder missverstanden fühlen. Im schlimmsten Fall schwächt das nicht nur das Vertrauen in KI-basierte Deliberation selbst, sondern in Demokratie insgesamt.

Eine besondere Gefahr besteht darin, dass KI-gestützte Deliberation neue Ungleichheiten politischer Teilhabe erzeugen kann. Wenn technische Lösungen vor allem denjenigen zugutekommen, die über digitale Kompetenzen, Vertrauen in KI oder entsprechende Ressourcen verfügen, kann politische Teilhabe insgesamt zwar wachsen, aber auch ungleicher verteilt werden.[2] Wir müssen deshalb darauf achten, dass die Einführung deliberativer KI nicht zu einem neuen “deliberative divide” führt.[3]

Eine weitere Herausforderung könnte man als “Skalierungsversuchung” bezeichnen.[4] Gerade Beteiligungsformate könnten durch den Einsatz von KI in einem zuvor nicht möglich gewesenen Maßstab skaliert werden.[5] Funktionierende Beteiligungsverfahren sind in der Regel sehr aufwendig: Bürger*innen müssen über teilweise komplexe Fachthemen informiert werden; ihnen wird oft die Möglichkeit gegeben, Argumente und Einwände auszutauschen; sie drücken ihre Standpunkte aus, die so aggregiert werden müssen, dass der Output der Beteiligung als Entscheidungsgrundlage für Politiker*innen dienen kann. Der Aufwand für die Organisation und Moderation solcher Formate sowie für die Analyse der Beiträge steigt dementsprechend sehr schnell mit der Menge der Teilnehmenden. KI, so die Hoffnung, kann viele dieser Aufgaben unterstützen oder gar übernehmen.[6] Die Skalierbarkeit eines Verfahrens ist jedoch keine Garantie für seine demokratische Legitimität. Vielmehr gilt es zu bedenken, dass alle normativen Anforderungen solcher Prozesse weiterhin erfüllt sein müssen. Die Ergebnisse von Beteiligungsverfahren sollen in die politische Willensbildung einfließen, die nur dann legitimiert ist, wenn das Verfahren selbst hinreichend legitimiert ist. Dabei geht es zum Beispiel um gleiche Teilhabe, Authentizität von Beiträgen, die Qualität des Outputs und eine Neutralität in der Moderation und Aggregation von Beiträgen. Ob die Erfüllung solcher normativen Anforderungen genauso gut skaliert wie die technischen Möglichkeiten, ist eine offene Frage.

Um welches Vertrauen geht es hier?

Neben dem schon beschriebenen Vertrauen in die Einhaltung politischer Rechte ist vor allem das Vertrauen in die Korrektheit und Unvoreingenommenheit von KI-generierten Inhalten und Analysen wichtig. Während Probleme durch Verzerrungen (Bias)[7] und Halluzinationen[8] von Sprachmodellen in der Forschung häufig thematisiert werden, erhalten andere Herausforderungen für die Zuverlässigkeit KI-generierter Resultate weniger Aufmerksamkeit. Betrachten wir als Beispiel die Erkennung von Hassrede. Die Frage, ob Äußerungen Hassrede enthalten, unterscheidet sich in vielerlei Hinsicht von der Messung einer physikalischen Eigenschaft:

- Begriffliche Vielfalt: Hassrede kann unterschiedlich definiert werden. Es gibt auch verwandte Begriffe wie toxic speech, uncivil speech oder offensive speech, die sich in ihrer Bedeutung leicht unterscheiden. Es muss explizit gemacht werden, welcher Begriff für die Erkennung von Hassrede herangezogen werden soll, wie er definiert ist, und geklärt werden, warum gerade dieser Begriff für die mit der Erkennung von Hassrede zusammenhängenden Normen relevant ist.

- Kontextabhängigkeit: Ob eine Äußerung als Hassrede zu kategorisieren ist, hängt oft vom Äußerungskontext ab, der nicht immer zugänglich ist. Für die Einordnung kann es z.B. notwendig sein zu wissen, worauf sich die Äußerung bezieht, von wem die Äußerung stammt, zu welcher Gruppe diese Person gehört und welche Intentionen die Person verfolgt.

- Graubereich: Selbst wenn Begriffe klar definiert sind und Kontextwissen vorliegt, bleibt oft ein Bereich, in dem nicht eindeutig entschieden werden kann, ob eine Äußerung Hassrede darstellt. Das liegt u.a. daran, dass Hassrede ein graduelles Phänomen ist. So muss man im Einzelfall abwägen, wo polemische Kritik aufhört und Hassrede beginnt. Die Beantwortung solcher Fragen wird zum Teil subjektiv ausfallen.

Die Herausforderungen von begrifflicher Vielfalt, Kontextabhängigkeit und nicht verschwindenden Graubereichen betreffen viele Anwendungen KI-gestützter Deliberation, weil es häufig um die Generierung und Analyse natürlicher Sprache geht, die in einem soziokulturellen und situativen Kontext eingebunden und damit im Einzelfall interpretationsoffen ist.

Lösungsansätze

Diese Herausforderungen sprechen nicht grundsätzlich gegen den Einsatz von KI – zumal sie gleichermaßen berücksichtigt werden müssen, wenn Menschen diese Aufgaben übernehmen. Gerade in deliberativen Kontexten sind Aufgaben, die KI unterstützen soll, häufig normativ aufgeladen und selten vollständig objektivierbar. Daher müssen KI-Systeme hier besonders vorsichtig, transparent und korrigierbar eingesetzt werden. Die folgenden Empfehlungen können dazu beitragen, durch Evaluation und Transparenz Vertrauen in KI-gestützte Deliberation zu schaffen:

- Transparente Evaluation: Die Leistung von KI-Anwendungen sollte durch Tests überprüft und die Ergebnisse sollten vollständig veröffentlicht werden. Dafür eignen sich zum Beispiel Testdatensätze, die – vereinfacht ausgedrückt – Aufgaben mit “Musterlösungen” enthalten. So kann gemessen werden, wie gut eine KI-Anwendung eine bestimmte Aufgabe löst. Die Qualität dieser Datensätze muss ebenfalls überprüfbar sein, insbesondere wegen der genannten Herausforderungen wie Interpretationsspielraum und Kontextabhängigkeit. Deshalb sollten die Datensätze frei zugänglich und gut dokumentiert sein, damit ihre Qualität unabhängig bewertet werden kann.

- Technologische Transparenz: Wenn die technischen Details einer KI-Anwendung nicht offengelegt werden, ist es schwer nachzuvollziehen, wie Ergebnisse entstehen. Dann kann auch nicht unabhängig geprüft werden, ob grundlegende Anforderungen wie z.B. Datensicherheit erfüllt sind. Technologische Transparenz bedeutet zum Beispiel die Offenlegung der verwendeten Modelle, des Pipelinesdesigns, der Prompts und der verwendeten IT-Infrastruktur. Ein hohes Maß an Offenheit erfordert auch die Veröffentlichung des Programmcodes und die Nutzung von Open-Weight-Modellen, die im Gegensatz zu proprietären Modellen wie ChatGPT frei verfügbar und selbst betreibbar sind. Bei technologischer Offenheit geht es nicht primär darum, dass Nutzer*innen in die Lage versetzt werden, Ergebnisse selbst zu reproduzieren, sondern dass unabhängige Dritte die KI-Anwendung kritisch überprüfen können. Solche unabhängigen Prüfungen und die Veröffentlichung der Ergebnisse bilden eine wichtige Grundlage für das Vertrauen von Nutzer*innen.

- Transparenz und Erklärbarkeit von Ergebnissen: Nutzer*innen sollten nachvollziehen können, wie und warum bestimmte Ergebnisse entstehen. Je nach Aufbau der KI-Anwendung gibt es dafür verschiedene Möglichkeiten: Wenn die KI zum Beispiel eine Websuche nutzt oder Informationen aus Dokumenten zieht, sollten diese Quellen und ihr Zusammenhang mit dem Ergebnis sichtbar sein. Wenn die KI ihr Ergebnis in mehreren Schritten erarbeitet, sollten auch die Zwischenergebnisse zugänglich sein.[9] Eine besondere Rolle kommt generativen Sprachmodellen zu: Von diesen kann man sich die Ergebnisse durch Rückfragen erklären lassen und Rechtfertigungen einfordern. Diese Möglichkeit sollte man an Nutzer*innen weitergeben.[10]

- Angabe von Unsicherheiten: Wie oben illustriert, gibt es in deliberativen Kontexten aufgrund von Interpretationsoffenheit und Kontextabhängigkeit nicht immer eindeutige Antworten. Diese Unsicherheiten KI-generierter Ergebnisse sollten nicht verwischt, sondern explizit gemacht werden. Statt eindeutiger Antworten könnten Unsicherheiten qualitativ oder quantitativ angegeben werden. Es ist auch möglich, dass KI-Anwendungen verschiedene Interpretationen aufzeigen oder sich bei unzureichender Informationslage einer Antwort explizit enthalten.

- Nutzer*innenkontrolle: Die Ergebnisse von KI-Applikationen sind in vielerlei Hinsicht fehlbar. Nutzer*innen sollten nicht nur die Möglichkeit haben, die Richtigkeit der Ergebnisse selbst zu prüfen (Punkt 3), sondern auch, sie zu hinterfragen und Korrekturen zu verlangen. Die aktive Einbindung der Nutzer*innen hilft nicht nur, KI-Anwendungen zu verbessern, sondern zeigt Nutze*innen auch, dass sie fehlerhaften Ergebnissen einer KI nicht ausgeliefert sind.

Diese Anforderungen formulieren Ideale, die in der Praxis mehr oder weniger stark umgesetzt werden können. Wie wichtig sie für einen bestimmten Anwendungsfall sind, lässt sich nicht pauschal beantworten, sondern hängt davon ab, wie relevant die genannten Herausforderungen im konkreten Fall sind. Darüber hinaus müssen die formulierten Gründe womöglich mit anderen Überlegungen abgewogen werden. So könnten sie beispielsweise mit berechtigten Geschäftsinteressen in Konflikt stehen. Hier gilt es, gesamtgesellschaftlich passende regulatorische Rahmenbedingungen für deliberative KI zu schaffen, um solche Konflikte möglichst gering zu halten.

KI besitzt ein großes Potential zur Unterstützung und Verbesserung deliberativer Prozesse. Ob sie das schafft, entscheidet sich jedoch nicht allein an der technischen Leistungsfähigkeit der KI-Anwendengen, sondern an ihrer Einbettung in transparente, überprüfbare und kontrollierbare Verfahren.

Quellen

- [1] Ähnliche und komplementäre Überlegungen finden sich im Beitrag von Marvin Sieger, der aus dem Projekt “Wegweiser.UX-für-KI” berichtet.

- [2] Diese Gefahr ist auch deswegen relevant, weil in der Forschung zu deliberativer KI die Anforderung gleicher Teilhabe weniger stark untersucht wird als andere Normen, wie ein aktueller Überblicksartikel zeigt.

- [3] Dieser Ausdruck stammt von Jungherr und Rauchfleisch (2025), die in einer repräsentativen Umfrage zeigen, dass eine allgemeine Skepsis gegenüber KI mit einer skeptischen Einstellung zu den Fähigkeiten deliberativer KI korreliert.

- [4] Die folgenden Punkte wurden auf dem KIdeKu-Workshop von Julian Müller und Eike Düvel vorgebracht.

- [5] Im Projekt “Künstliche Intelligenz und Bürgerräte” (KIB) werden Einsatzmöglichkeiten von KI in der Öffentlichkeitsbeteiligung untersucht.

- [6] Vgl. bspw. Michael Tessler u.a. 2025.

- [7] Einen Überblick liefern Anna Lena Emonds und Julia Kaballo vom Fraunhofer IAIS in ihrem Beitrag “Bewusste Nutzung von Large Language Models: Wie lassen sich Bias vermeiden?”.

- [8] Einen Überblick liefert Julien Siebert vom Fraunhofer IESE im Beitrag “Halluzinationen von generativer KI und großen Sprachmodellen (LLMs)”.

- [9] Bei den neueren Reasoning-Modellen sollte bspw. die Reasoning Trace für Nutzer:innen transparent gemacht werden.

- [10] Selbst wenn diese nachgelagerten Erklärungen und Rechtfertigungen nicht kausal für die Ergebnisse ursächlich sind, können sie für mehr Akzeptanz sorgen und darüber hinaus als Grundlage für die Legitimierung der Ergebnisse dienen.